1、从能上网的电脑上下载3个文件 :

ollama安装文件: OllamaSetup.exe

chatbox安装文件: Chatbox-1.11.5-Setup.exe

2、将这3个文件复制到d:\ollama (我们是为了把所有程序都安装到此目录)

在D盘或其他盘内创建一个名为ollama的文件夹,将ollama安装包移动至该文件夹内

在cmd命令窗口输入“D:”将目录切换到D盘 输入该指令: setx OLLAMA_MODELS d:\ollama\models/M 然后回车,提示“成功”就说明输入成功了 接下来继续 输入cd ollama 回车 再输入OllamaSetup.exe /dir=d:\ollama 回车 等待一会后,会自动弹出该界面,点击“Install/安装”进行安装 检测是否安装成功:在cmd令窗口输入:D: 回车

输入:cd ollama 回车 再输入ollama -v,如果像下面这样 显示“ollama version is 0.5.12” 就是安装成功了

3、设置环境变量

在D盘创建一个用于安装ollama模型的文件夹,文件夹名称设置成“ollamamx”(文件夹名称可以自定义)

创建一个“系统变量”, 变量名:OLLAMA_MODELS 变量值:在“浏览目录”找到我们刚才在D盘创建的“ollamamx”文件夹 下面我们再创建一个跟“系统变量”一样的“用户变量”

然后把ollama退出重新打开:桌面右下角找到“ollama” 鼠标右键点击选择“Quit ollama/退出ollama” 退出后再打开ollama 4、 下载大模型文件 如果部署的服务器无法直接连外网,可以先在能上网的一台笔记本上按照上述说明部署一个环境,然后在 cmd窗口输入: ollama run deepseek-r1:14b (可以从官网https://ollama.com/library/deepseek-r1找到下载不同大型模的命令) 大模型文件开始下载 等下载完成后,将ollamamx 文件夹复制到部署的服务器上,替换服务器上的ollamamx文件夹。

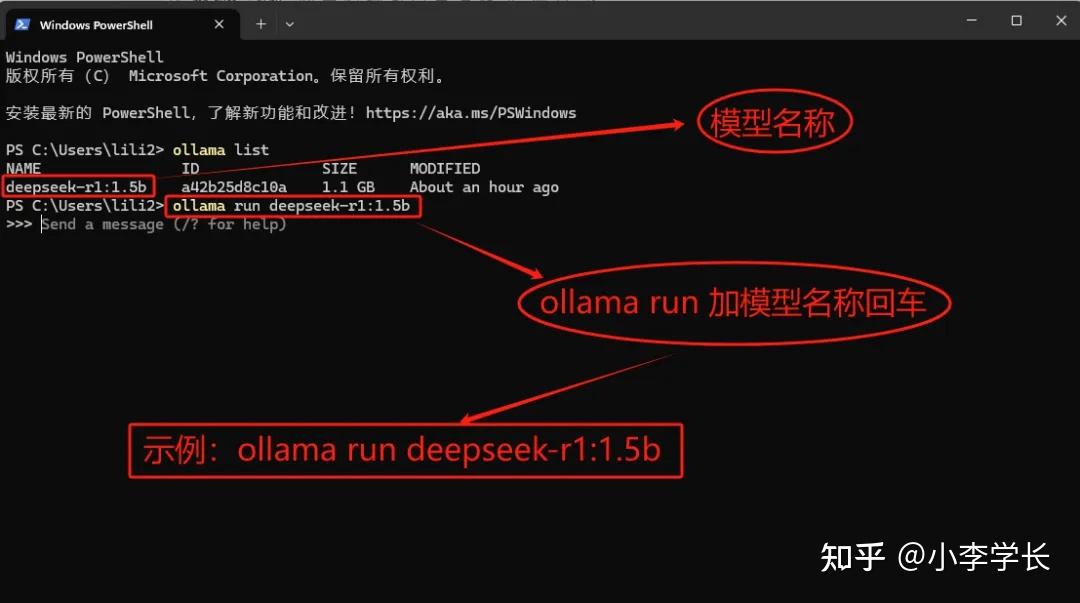

5、cmd窗口输入:ollama list 回车 查看已安装的模型 复制模型名称然后在指令窗口输入:ollama run 模型名称 回车即可进入对话

如何退出对话? A:指令窗口输入:/bye

6、部署chatbox 安装chatbox,点击左下角的设置 -模型提供方 选择: OLLAMAAPI 模型选择 deepseek-r1:14b---保存

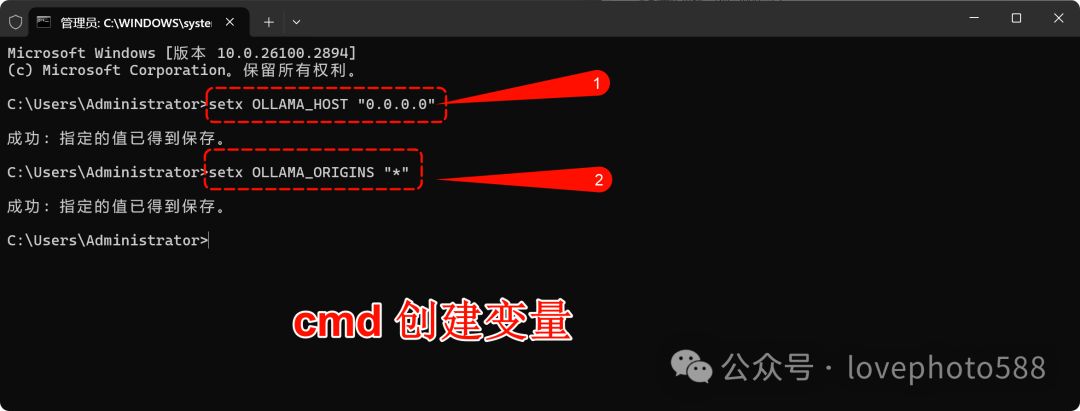

7、设置局域网访问:

默认Ollama仅允许本地访问,需创建Ollama变量,并设置系统环境变

使用管理员身份打开 cmd窗口 执行如下命令:

setx OLLAMA_HOST "0.0.0.0"

setx OLLAMA_ORIGINS "*"

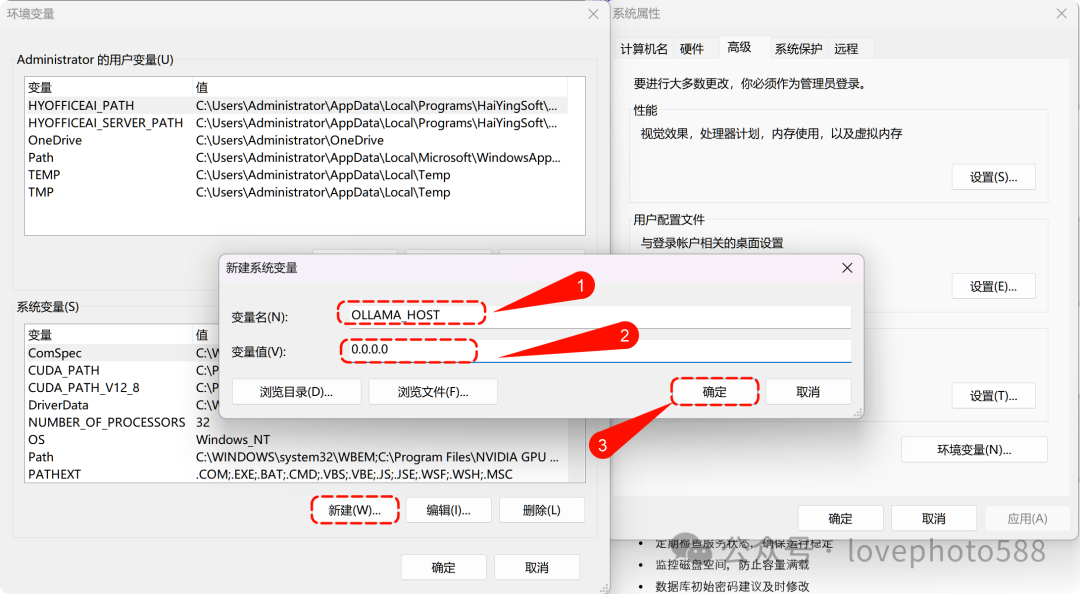

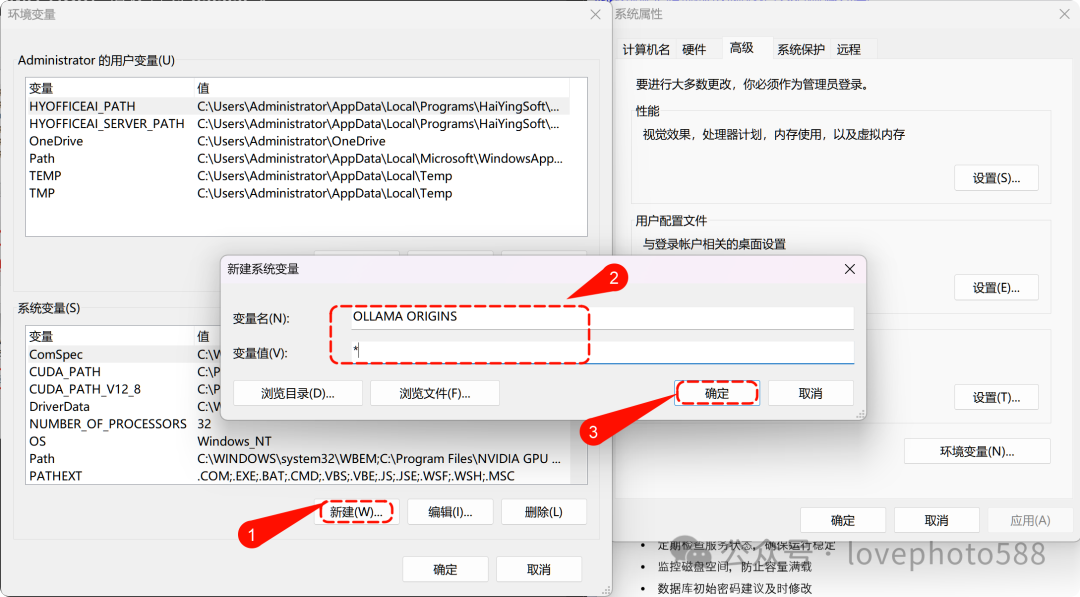

然后设置两个系统环境变量

系统变量OLLAMA_HOST 值设置为 0.0.0.0

系统变量OLLAMA ORIGINS 值设置为 * (备注 OLLAMA和 ORIGINS中间是空格,不是下划线)

电脑右下角右键退出 Ollama程序后,重新启动Ollama程序。

进入 chatbox 设置, api域名由 http://127.0.0.1:11434修改为 http://ip:11434

局域网中其他电脑上:

安装chatbox软件, 然后设置-模型提供方 选择: OLLAMAAPI API域名:http://ip:11434 模型选择 deepseek-r1:14b---保存

部署本地知识库

1、下载 AnythingLLM,https://anythingllm.com/desktop

2、在离线服务器上安装时,安装目录 d:\AnythingLLm,安装完之后会报错,提示需要联网下载一些依赖库。

3、找一台联网的机器,安装 anythingLLM,安装速度比较慢,而且最后也报错了,根据网上的建议,将dns修改为8.8.8.8,然后安装python,重新安装,安装正常。然后将D:\deepseek\AnythingLLM\resources\ollama\lib 目录复制覆盖到离线服务器上。

4、打开anythingllm-配置:

外观-displaylanguage 选择 chinese

LLM首选项: LLM提供商,选择 Ollama

向量数据库: 不变,默认的免费,其他有速度更快的,但是收费

Embedder首选项:嵌入引擎提供商: Ollama

保存

5、创建新工作区,工作区右侧点击设置

聊天设置:工作区LLM提供者 Ollama,聊天模式:查询,聊天提示:改为: 你是一个知识库专家,所有问题请用中文回答

6、向量数据库: 搜索偏好: Accuracy Optimized(准确性提升) ,最大上下文片段,改为10

7、代理配置: Ollama

8、本地知识库上传。

发现问题: AnythingLLM 只能单人使用,局域网中其他用户无法使用,除非其他人再安装AnythingLLM,但是其他人安装AnythinkLLM 又需要配置知识库,上传知识库。

9、所以需要安装 Docker AnythingLLM的方式,可以供局域网用户使用。

经过测试,AnythingLLM 搜索效果不理想, 后面准备安装 ragflow

首先需要确保服务器操作系统版本满足 docker desktop 最低要求( win10 19044之上),如果不满足,请先联网更新系统,建议升级至19045

1、在 BIOS/UEFI 中启用 Intel VT-x/AMD-V

启用必需的 Windows 功能- 启用“虚拟机平台”与“适用于 Linux 的 Windows 子系统”

- 打开【控制面板】→【程序】→【启用或关闭 Windows 功能】。

- 勾选Hyper-V 、虚拟机平台、适用于 Linux 的 Windows 子系统,媒体功能、远程差分压缩API支持

2、启用 WSL 功能powershellCopy#

以管理员身份运行 PowerShell dism.exe /online /enable-feature /featurename:Microsoft-Windows-Subsystem-Linux /all /norestart

dism.exe /online /enable-feature /featurename:VirtualMachinePlatform /all /norestart

wsl --install (如果此步骤卡住,或无法运行,可以将 适用于 Linux 的 Windows 子系统功能删除,然后再执行 wsl --install

wsl --update

wsl --set-default-version 2

Restart-Computer

- 开始菜单中出现 Ubuntu 虚拟机,第一次运行时会提示建立用户:

在 PowerShell 终端或 Ubuntu 窗口中,按照以下步骤输入信息: 1️⃣ 输入你的 UNIX 用户名在 Enter new UNIX username: 后输入你想要的 Linux 账户名,例如:administrator

然后按 Enter。

✅ 注意:

- 不能使用大写字母。

- 不能有空格。

- 这个用户名将是默认用户,具有 sudo 权限(类似 Windows 的管理员权限)。

2️⃣ 创建一个密码 它会提示:

Enter new UNIX password: 输入你的密码(⚠️ 输入时不会显示任何字符,这是 Linux 的安全特性),然后按 Enter。 ✅ 密码要求: - 必须记住这个密码! 因为以后使用 sudo(管理员权限)时需要输入它。

- 至少6个字符,尽量使用大小写字母、数字、特殊字符的组合,以增强安全性。

3️⃣ 确认密码Retype new UNIX password:

再次输入 相同的密码,然后按 Enter。 如果输入正确,你会看到类似: passwd: password updated successfullyInstallation successful!

说明你的 WSL Ubuntu 用户已创建,并且安装完成 !

四. 接下来可以做什么?1️⃣ 测试 Ubuntu 是否成功安装 在 Ubuntu 终端中输入:

whoami 如果返回的是你的用户名(例如 tracy),说明账户创建成功。 2️⃣ 检查 WSL 版本 在 PowerShell 运行: wsl --list --verbose

如果返回: NAME STATE VERSIONUbuntu-22.04 Running 2

说明 WSL 2 已成功启用。 3️⃣ 更新 Ubuntu 首次使用建议更新系统软件,在 Ubuntu 终端中输入:<br/>sudo apt update && sudo apt upgrade -y<br/> 然后输入刚才创建的 密码 进行更新。

你现在可以开始使用 Ubuntu 22.04 了!你可以: - 在 PowerShell 或 CMD 运行 wsl 进入 Linux 终端:powershell

wsl - 使用 exit 退出 WSLsh

exit - 直接在 Windows 终端中打开 Ubuntu 按 Win + S 搜索 Ubuntu 22.04,打开即可。

- 点击确定后,重启计算机。

安装 ragflow

1、下载 ragflow https://github.com/infiniflow/ragflow 两种方法,一种直接下载,另一种使用 git clone https://github.com/infiniflow/ragflow.git

2、安装docker

到docker官网下载4.29.0版本安装包(4.30.0及以上不支持更改镜像)。

安装docker之后,点击桌面上的 docker图标进入,然后修改镜像源:

docker默认不允许修改,进入设置-General, 选中/或不选中 Expose daemon on tcp:/localhost:2375 without TLS 之后,就允许修改了

点击 Docker Engine,将文本框中的内容替换为:

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false,

"registry-mirrors": [

"http://mirrors.ustc.edu.cn",

"http://hub-mirror.c.163.com",

"https://docker.hpcloud.cloud",

"https://docker.m.daocloud.io",

"https://docker.unsee.tech",

"https://docker.1panel.live",

"https://docker.chenby.cn",

"http://mirror.azure.cn",

"https://dockerpull.org",

"https://dockerhub.icu",

"https://hub.rat.dev"

]

}

点击 apply&restart

3、找到刚才下载好的 ragflow 文件夹, 进入 d:\deepseek\ragflow\docker

编辑 .env文件, 将RAGFLOW_IMAGE=infiniflow/ragflow:v0.18.0-slim 注释掉,将RAGFLOW_IMAGE=infiniflow/ragflow:v0.18.0 取消注释

4、cmd

d:\deepseek\ragflow> docker compose -f docker/docker-compose.yml up -d

第一次运行,速度很慢,运行完成后,

打开网页,输入 localhost:80

这里注意, 有的浏览器localhost:80 只有标题显示ragflow,页面是空白,这是浏览器不支持,更换微软浏览器或者firefox 确认可以登录。

注册账号登录

修改语言为中文

点击最右侧的设置按钮-模型提供商 添加模型 Ollama , [chat deepseek-r1:14b http://ip:11434 ]

设置默认模型: deepseek-r1:14b 嵌入模型 默认, 保存

创建知识库 ,上传文档

聊天-创建助理

聊天测试。

|  |手机版|小黑屋|电脑计算机论坛

( 京ICP备2022023538号-1 )

|手机版|小黑屋|电脑计算机论坛

( 京ICP备2022023538号-1 )